Ein Cache ist ein sehr schneller Speicher mit verhältnismäßig kleiner Speicherkapazität, der als Puffer zwischen der Zentraleinheit ( CPU) und dem Arbeitsspeicher angeordnet ist. Der Sinn dieses Speichers besteht darin, den Zugriff auf häufig benutzte Programmteile und Daten zu beschleunigen. Abspeichern und Lesen geschieht vollautomatisch, indem die Zugriffshäufigkeit der einzelnen Speicherbereiche überwacht wird und die am seltensten benutzten Bereiche als erste überschrieben werden. Das Cache wird von einem speziellen Programm oder direkt vom Betriebssystem verwaltet.

In Cache-Speichern werden in der Regel Static RAMs ( SRAM) eingesetzt, da die Zugriffszeiten kürzer sind als die von Dynamic RAMs ( DRAM).

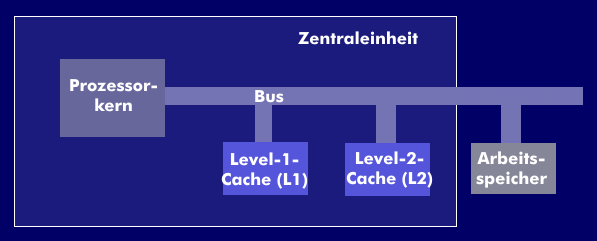

Hierachien der Cache-Speicher

Cache-Speicher werden in Hierarchien unterteilt und je nach der Position, die sie im Datenstrom einnehmen mit Leveln bezeichnet. So ist ein Level-0-Cache ein kleiner Speicher, von wenigen Byte, der den Datenstrom in der Zentraleinheit entkoppelt. Ein Level-1-Cache ( L1) oder First Level Cache ist ebenfalls ein internes Cache ebenso wie das Level-2-Cache ( L2). Das Level-3-Cache ( L3) ein separater Speicher auf dem Motherboard.

Neben den Memory-Caches gibt es auch Caches für Disketten-, CD- und DVD-Laufwerke. Dieses Zwischenspeicher verwenden keine SRAMs sondern konventionelle Speichertechniken in denen die Daten zwischengespeichert werden.

Die Arbeitsweise der Cache-Speicher

Nach der internen Arbeitsweise unterscheidet man Cache-Speicher in asynchrone Caches (A-Cache), synchrone Caches (S-Cache), Burst-Caches (B-Cache) und Pipeline Burst Cache ( PB-Cache). Die asynchronen Caches arbeiten asynchron zum CPU- Takt und sind wie die DRAMs in Speicherbänken organisiert. Die synchronen Caches arbeiten als SRAMs und werden von dem CPU-Taktsignal getaktet. Sie sind schneller als die A-Caches und haben Zugriffszeiten von unter 20 ns. Die B-Caches können nach Übertragung der Startadresse die folgenden Adressen selbst erzeugen, wodurch Overhead entfällt und die Datenrate gesteigert wird. Als PB-Caches werden PBSRAMs (Pipelined Burst SRAM) eingesetzt, die sich durch einen besonders kurzen Lesezyklus auszeichnen.

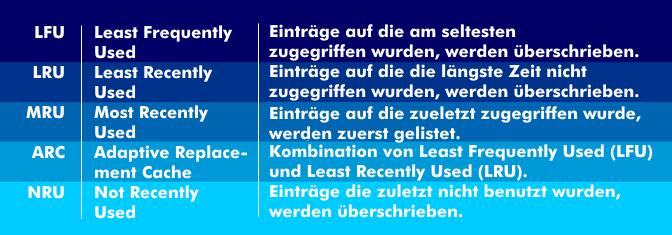

Die interne Organisation für neu eingelesene und auszulesende Speicherblöcke ist durch Cache- Algorithmen festgelegt. Dabei geht es darum wie ältere Datenblöcke durch neuere Datenblöcke ersetzt werden. Es gibt mehrere Verdrängungsstrategien, so Least Frequently Used ( LFU), Least Recently Used ( LRU), Most Recently Used ( MRU), Not Recently Used ( NRU) und Adaptive Replacement Cache ( ARC).

Ein wichtiger Parameter von Cache-Speichern ist die sogenannte Hit-Rate, die die Häufigkeit der im Cache gefundenen Daten repräsentiert. Cache-Speicher können Bestandteil der Mikroprozessor- Architektur sein und beispielsweise eine Speicherkapazität von 8 KB oder 16 KB haben, wie im Pentium- Prozessor.